MODELOS GIGANTES

En los últimos años, la evolución de la IA ha estado dominada por aumentos exponenciales en los parámetros de diseño y en el volumen de datos de entrenamiento.

¿100 billones?

GPT-4 de OpenAI*

1,2 billones

GLaM de Google

530.000 millones

Megatron-Turing NLG de Microsoft

280.000 millones

Gopher de DeepMind

175.000 millones

GPT-3 de OpenAI

17.000 millones

GPT-2 de OpenAI

*La organización no ha divulgado detalles sobre su último modelo, pero en 2021 afirmó que podría alcanzar los 100 billones de parámetros

Número de parámetros

2022

2021

2021

2021

2020

2019

2024

OpenAI utiliza GPT-3 para crear Dall-e. Un año después nace Dall-e 2 y rivales como Midjourney y Stable Diffusion. Europa publica un borrador para la directiva para regular la IA.

OpenAI presenta GPT-3. Su adaptación en chatbot dará lugar a ChatGPT en 2022 y a GPT-4 en 2023. Google lanza T5 junto al conjunto de datos de código abierto C4 para entrenamiento de LLM.

2021

2020

Google lanza Google Duplex, un asistente de voz cuyas respuestas suenan casi humanas, y Bert, un nuevo modelo de reconocimiento de lenguaje no supervisado en código abierto.

2018

Google arranca la era AI First y publica su primer paper sobre la arquitectura de red neuronal tipo transformador que sentará las bases de los grandes modelos de lenguaje.

2017

AlphaGo de Google DeepMind derrota al campeón mundial de go Lee Sedol por 4-1. Su siguiente iteración, AlphaGo Zero, llega a ser considerada como “una inteligencia casi alienígena”.

2016

2016 Google/Getty Images

Retransmisión en directo de la Google DeepMind Challenge Match.

Nace Tensorflow de Google, un framework de desarrollo con librerías para el entrenamiento e inferencia multiplataforma opensource.

2015

Ian Goodfellow idea las redes generativas antagónicas (GAN) que darán lugar a la era de los deepfakes hiperrealistas y a los algoritmos de transferencia de estilo.

2014

La revista MIT Technology Review incluye el aprendizaje profundo en la lista de las 10 Tecnologías Emergentes.

2013

Los chatbots inteligentes empiezan a proliferar. Apple lanza a Siri, Google presenta a Google Now y Amazon crea a Cortana.

2011-2014

La era del aprendizaje profundo

2010 - 2022

Deep Blue de IBM derrota al maestro del ajedrez Garry Kasparov. 20 años después publica su libro Deep Thinking en el que admite que la máquina no hizo trampas.

1997

Yvonne Hemsey/Getty Images

Captura de pantalla de Deep Blue durante la partida contra Kasparov.

El segundo invierno de la inteligencia artificial. Tendrían que pasar casi 30 años para que el avance Minsky con las redes neuronales diera lugar a la era del apredizaje profundo.

1987-1993

Marvin Minsky, uno de los padres de la IA, utiliza la técnica de la retropropagación para entrenar una red neuronal. Este hito se considera la base del aprendizaje profundo.

1986

Distintos fracasos en varias investigaciones dan lugar al primer invierno de la inteligencia artifical. La financiación se reduce y muchos proyectos se abandonan.

1974-1980

¿100 billones?

GPT-4 de OpenAI* - 2022

1,2 billones

GLaM de Google - 2021

530.000 millones

Megatron-Turing NLG de Microsoft - 2021

280.000 millones

Gopher de DeepMind - 2021

175.000 millones

GPT-3 de OpenAI - 2020

17.000 millones

GPT-2 de OpenAI - 2019

*La organización no ha divulgado detalles sobre su último modelo, pero en 2021 afirmó que podría alcanzar los 100 billones de parámetros

Número de parámetros

Nace ELIZA , el primer programa de IA capaz de procesar el lenguaje natural (solo en inglés). Su incapacidad para comprender lo que decía quedó clara en seguida.

1966

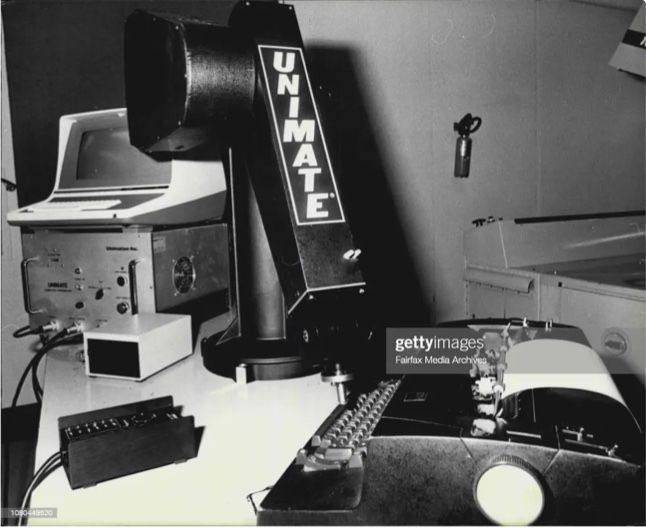

Unimate, el primer robot industrial, empieza a trabajar para General Motors. Se trata de un robot preprogamado incapaz e reaccionar a los cambios del entorno.

1961

Evolución del robot UNIMATE siriviendo una taza de café en 1967.

1956

Se acuña el término “inteligencia artifical” en una conferencia. Entre sus asistentes había científicos que acabarían siendo considerados los padres de la IA.

1951

William Shockley inventa el transistor de unión que hizo posible una nueva generación de computadoras mucho más rápidas y pequeñas.

1950

Alan Turing diseña el famoso Test de Turing para comprobar si una máquina es realmente inteligente.

¿Alguien se siente capaz de predecir qué nos deparan los imparables avances de la inteligencia artificial?

La evolución de la IA no habría sido posible sin dos características

La era de los modelos gigantes

La era de la gran escala

2015 - 2022

Rocky Acosta - Own work, CC 3.0,

Reconstrucción física de la Máquina de Turing realizada por Mike Davey.

La era previa al aprendizaje profundo

1952 – 1997

La era de

la gran escala

2015 – 2022*

La era del aprendizaje profundo

2010 – 2022*

La era previa al aprendizaje profundo

1952 – 2010

UNA HISTORIA EN TRES ACTOS

*El final de la era 2 se solapa con el inicio de la 3 porque ambas corresponden dos tendencias diferentes en cuanto al diseño y desarrollo de los modelos de aprendizaje automático.

La evolución de la IA está salpicada por avances entremezclados que se influyen mutuamente. Centrar el análisis en los modelos de aprendizaje de máquinas disponibles permite dividir su trayectoria en tres etapas.

Breve historia de la inteligencia artificial

A hombros de gigantes